Os recursos de proteção infantil da Apple têm uma grande falha de design

O plano da Apple de lançar recursos para limitar a disseminação de material contendo abuso sexual infantil (CSAM) foi elogiado por alguns especialistas em privacidade e segurança, bem como por grupos de proteção à criança.

Porém, essas preocupações ofuscaram um outro problema, ainda mais grave: o novo recurso da Apple utiliza um design que pesquisas apontam ser falho e que acabam causando o efeito contrário.

Um desses recursos é uma opção de controle parental de mensagens, que bloqueia a visualização de imagens sexualmente explícitas. A expectativa é que o monitoramento dos pais sobre o comportamento da criança diminua a visualização e envio de fotos com conteúdo sexual. Mas isso é altamente questionável.

Somos dois psicólogos e um cientista da computação. Conduzimos uma extensa pesquisa sobre porque as pessoas compartilham imagens deste tipo na internet. Nossa pesquisa recente revela que os avisos sobre privacidade nas redes sociais não reduzem o compartilhamento de fotos nem aumentam a preocupação com a privacidade. Na verdade, esses avisos, como os dos recursos de proteção infantil da Apple, podem aumentar, em vez de reduzir, o compartilhamento de fotos impróprias.

RECURSOS DE PROTEÇÃO INFANTIL DA APPLE

A Apple anunciou no dia 5 de agosto de 2021 que planeja introduzir novos recursos para proteger crianças de três formas. Primeiramente, apresenta um recurso que auxilia pais ou crianças que se deparem com material potencialmente perigoso no aplicativo de busca da Apple ou na assistente virtual Siri.

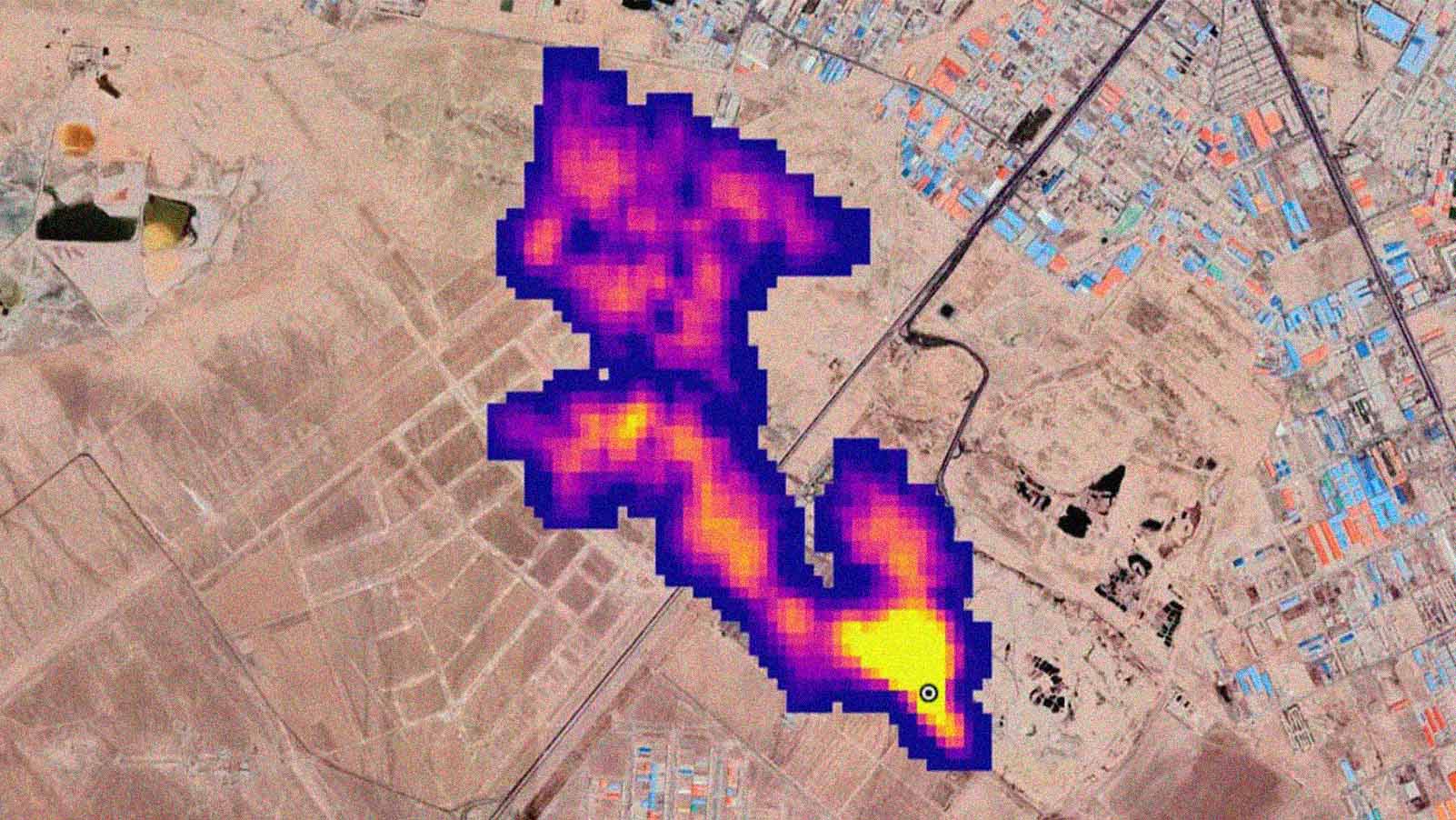

Seu segundo recurso fará uma varredura nas imagens, tanto nos dispositivos quanto no iCloud Photos, afim de identificar correspondências em um banco de dados de imagens de abuso sexual infantil fornecido pelo Centro Nacional para Crianças Desaparecidas e Exploradas e outras organizações de proteção à criança. Caso aponte presença de material impróprio, a Apple analisa manualmente cada correspondência para confirmar o conteúdo da foto e, em seguida, desativa a conta do usuário e envia um relatório para o centro. Este recurso, porém, gerou muita polêmica.

O último recurso adiciona uma opção de controle parental ao “Mensagens”, aplicativo de SMS da Apple, que desfoca imagens sexualmente explícitas quando ativado, avisando o usuário quanto ao conteúdo. Se o usuário tiver 12 anos ou menos, os pais receberão uma mensagem caso a criança veja ou compartilhe uma foto imprópria.

Porém, há pouca discussão sobre este recurso, talvez porque o consenso é que o controle parental é necessário e eficaz. No entanto, nem sempre é o caso e esses avisos podem causar o efeito contrário.

QUANDO AVISOS CAUSAM O EFEITO OPOSTO

Em geral, pessoas tendem a evitar o compartilhamento de material impróprio, mas é importante reduzir a frequência com que isso ocorre. Uma análise de 39 estudos descobriu que 12% dos jovens encaminharam um “sext” (mensagem de texto com conteúdo adulto), imagem ou vídeo sexualmente explícito, enquanto, 8,4% tiveram um “sext” seu encaminhado sem consentimento. Os avisos podem parecer a forma mais adequada de reduzir o compartilhamento impróprio. Mas, ao contrário do que se esperava, descobrimos que os avisos sobre violações de privacidade costumam gerar o efeito oposto.